ΒΡΕΘΗΚΕ ΤΡΟΠΟΣ ΝΑ ΜΗ ΣΕ ΞΕΓΕΛΑ Η ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ

Πόσο εύκολα μπορούμε να ξεχωρίσουμε το αληθινό από την τεχνητή νοημοσύνη; Έρευνες δείχνουν ότι η ανθρώπινη ακρίβεια αγγίζει το 50%, δηλαδή κορώνα-γράμματα.

Το «πάμε κατά διαόλου» ή «πού πάμε τέλος πάντων;» είναι φράσεις που συμπυκνώνουν τις σκέψεις μου κάθε που διαβάζω σχόλια κάτω από βιντεάκια τεχνητής νοημοσύνης (ΑΙ). Βασικά, κάτι έχω στο μυαλό μου για το πού πάμε: από το κακό στο χειρότερο. Δεν μιλάμε πλέον για απλούς χρήστες του YouTube ή άλλης πλατφόρμας που την πατάνε από τo ΑΙ –και τους αρχίζουν πόλεμο εκείνοι που όλα τα καταλαβαίνουν–, αλλά για δουλειά που ξεγελά ακόμα και έγκριτα δημοσιογραφικά μέσα.

Η μηχανή εξελίσσεται ταχέως και απαλλάσσεται από ελαττώματα που κάποτε θα πρόδιδαν το ψέμα. Για παράδειγμα, τα πρόσωπα που παράγει σήμερα το AI μπερδεύουν και τους πιο επιτήδειους και κρίνονται συχνά ως πιο ρεαλιστικά από πορτρέτα πραγματικών ανθρώπων. Κι αν ήταν μόνο ότι χάψαμε ως αληθινά τα τεχνητά δεδομένα, μικρό το κακό. Το πρόβλημα είναι πως, με τον καιρό, γινόμαστε όλοι –ακόμη και οι ψηφιακά εγγράμματοι– υποψήφια θύματα ηλεκτρονικής (ή άλλης) απάτης.

Πρόσφατη έρευνα από το Πανεπιστήμιο του Leeds δοκίμασε 664 εθελοντές, ανάμεσα στους οποίους και super‑recognizers, ως προς την ικανότητά τους να διακρίνουν τα αληθινά από τα AI πρόσωπα. Οι super‑recognizers, άτομα που επέδειξαν εξαιρετική ικανότητα στη σύγκριση και αναγνώριση πραγματικών προσώπων σε προηγούμενες μελέτες, φαίνεται πως δυσκολεύτηκαν εν προκειμένω, αφού αναγνώρισαν μόλις 41% των δημιουργημάτων τεχνητής νοημοσύνης. Για τον μέσο συμμετέχοντα, το ποσοστό έπεσε στο 31%.

Αρκούν 5 λεπτά για να μη σε ξεγελά το ΑΙ;

Από τη μελέτη δεν έλειψαν τα παρήγορα ευρήματα, όπως ότι μια εκπαίδευση πέντε μόλις λεπτών ανέβασε τα ποσοστά επιτυχίας. Τόσο οι super‑recognizers όσο και οι μεσαίων δυνατοτήτων συμμετέχοντες, αφού εκπαιδεύτηκαν να αναγνωρίζουν ύποπτα σημάδια, όπως δόντια που λείπουν ή θαμπό περίγραμμα στα μαλλιά και το δέρμα, αύξησαν τα ποσοστά ακριβείας στο 64% και 51% αντίστοιχα. Σύμφωνα με την ερευνητική ομάδα, η διαφορά δείχνει πως η λύση δεν είναι απλώς θέμα εκπαίδευσης, τουλάχιστον όχι για τον μέσο άνθρωπο, που μπόρεσε μετά βίας να ξεπεράσει το όριο του 50%.

Το κρυφό χαρτί της τεχνητής νοημοσύνης

Τα generative adversarial networks, η τεχνολογία πίσω από αυτά τα ψεύτικα πρόσωπα, βασίζονται στη συνεργασία δύο αλγορίθμων, ενός που δημιουργεί πρόσωπα και ενός δεύτερου που αξιολογεί πόσο ρεαλιστικά είναι σε σχέση με πραγματικούς ανθρώπους. Το συνεχές feedback και η διαρκής βελτίωση οδηγούν στα σημερινά αποτελέσματα.

Πέρα από την ταχύτητα, ανησυχητική είναι και η ευκολία παραγωγής fake περιεχομένου. Αυτό που πριν λίγα χρόνια απαιτούσε εξειδικευμένη τεχνική γνώση, μπορεί πλέον να γίνει γρήγορα και με λίγο κόπο από οποιονδήποτε έχει πρόσβαση στο διαδίκτυο. Εφαρμογές γνωριμιών, κοινωνικά δίκτυα και online marketplaces έχουν μετατραπεί σε πεδία παραγωγής και προβολής συνθετικών δεδομένων.

Ποιοι είναι οι πιο ευάλωτοι

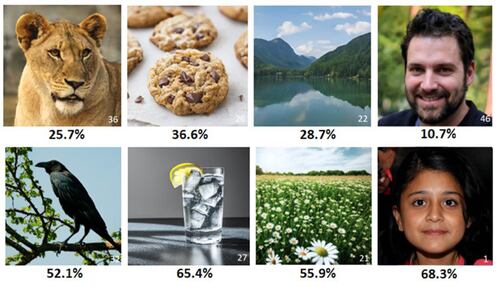

Άλλη βρετανική μελέτη διεύρυνε την υπόθεση εργασίας και εξέτασε την ανθρώπινη ικανότητα διάκρισης του αληθινού από το τεχνητό σε πολλαπλές μορφές περιεχομένου (εικόνες, ήχος, βίντεο και οπτικοακουστικά ερεθίσματα), καταλήγοντας ότι τα ποσοστά ακρίβειας κυμαίνονταν στο 51% για όλες τις κατηγορίες.

Ωστόσο, διερεύνησε και πώς συγκεκριμένα χαρακτηριστικά επηρεάζουν την απόδοση και συμπέρανε ότι:

- Οι άνθρωποι δυσκολεύτηκαν περισσότερο να διακρίνουν τα συνθετικά δεδομένα από τα αληθινά.

- Οι εικόνες με πρόσωπα ανθρώπων δυσκόλεψαν περισσότερο από εκείνες ζώων και τοπίων.

- Η διάκριση αληθινού-τεχνητού ήταν λιγάκι πιο εύκολη σε πολυτροπικό περιεχόμενο (συνδυασμός ήχου και εικόνας).

- Η γλώσσα αποδείχθηκε κρίσιμος παράγοντας· οι εθελοντές δυσκολεύονταν να διακρίνουν τη φύση του περιεχομένου αν δεν μιλούσαν άπταιστα τη γλώσσα.

- Οι μεγαλύτεροι σε ηλικία συμμετέχοντες τα πήγαν χειρότερα από τους νεότερους, ιδιαίτερα σε ηχητικό και οπτικοακουστικό περιεχόμενο.

Κάτω σειρά: συνθετικές εικόνες που αναγνωρίστηκαν πιο συχνά σωστά ως τεχνητές.

Κάτω από κάθε εικόνα φαίνεται το μέσο ποσοστό σωστών απαντήσεων.

Σε κάθε περίπτωση, ακόμη και οι συμμετέχοντες που δήλωσαν πολύ εξοικειωμένοι με τα συνθετικά δεδομένα δεν τα πήγαν καλύτερα από όσους δήλωσαν παντελή άγνοια. Σύμφωνα με τους ερευνητές, αυτό μπορεί να σημαίνει δύο πράγματα: είτε ότι οι δυνατότητες της τεχνητής νοημοσύνης εξελίχθηκαν σε σημείο να ακυρώνουν την προϋπάρχουσα γνώση, είτε ότι συνολικά η ικανότητα του κοινού να διακρίνει το AI περιεχόμενο είναι ακόμα πολύ περιορισμένη.

Υπάρχουν λύσεις;

Πέρα από τη στοχευμένη εκπαίδευση που προτείνει η έρευνα από το Πανεπιστήμιο του Leeds, έχουν προταθεί και άλλα προστατευτικά μέτρα, όπως:

- συστήματα μηχανικής ανίχνευσης,

- τεχνολογίες πιστοποίησης του περιεχομένου με υδατογράφημα,

- παρακολούθηση της προέλευσης του περιεχομένου και

- κρυπτογράφηση (ψηφιακές υπογραφές).

Κάποιες βραχυπρόθεσμες λύσεις θα μπορούσαν να αποτελέσουν οι ειδικές πολιτικές ανά πλατφόρμα. Για παράδειγμα, αφού η παρουσία ήχου διευκολύνει την αναγνώριση του fake περιεχομένου, τα κοινωνικά δίκτυα θα μπορούσαν να απενεργοποιήσουν το αυτόματο mute σε περιεχόμενο που επισημαίνεται ως πιθανώς παραπλανητικό.